Intelligence artificielle

Marvin Amuzu ∙23 Avr 2025∙ 3 min

Jusqu’à présent, les modèles d’intelligence artificielle qui traitent du texte (comme ChatGPT, Llama, etc.) utilisent ce qu’on appelle un tokenizer. C’est un système qui découpe les textes en “mots” ou en morceaux de mots appelés tokens. Par exemple, “chat” est un token, mais un mot plus long ou rare va être découpé en plusieurs tokens. Ce découpage dépend d’un dictionnaire et de certaines règles, qui sont elles-mêmes apprises à partir de textes existants, souvent en anglais.

Cette méthode n’est pas idéale pour toutes les langues. Par exemple, pour le français, les mots sont plus souvent découpés en plusieurs tokens qu’en anglais. C’est encore plus vrai pour les langues peu représentées dans les bases de données. Résultat : il faut plus de calculs pour comprendre ou générer une phrase dans ces langues (parce qu’au lieu de manipuler un seul token par mot, le modèle manipule plusieurs morceaux), ce qui coûte plus cher et peut diminuer la qualité.

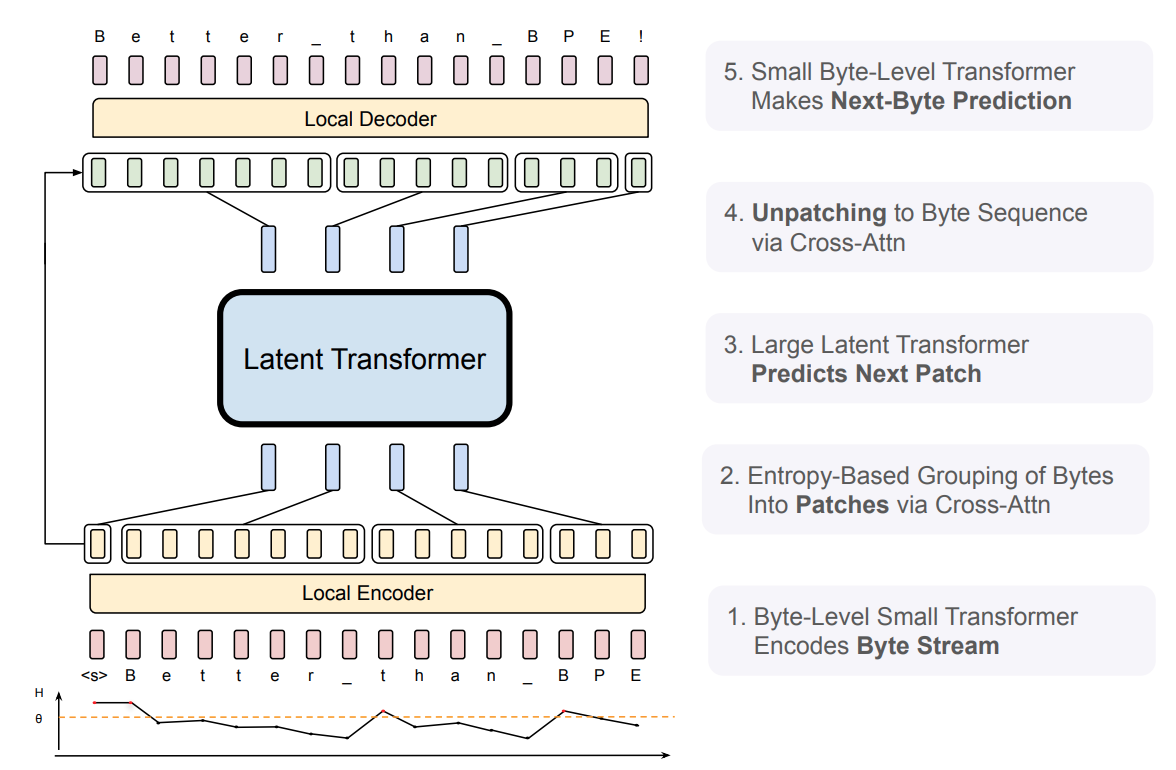

Au lieu de découper le texte en tokens selon un dictionnaire, BLT travaille directement sur les bytes (octets) du texte, c’est-à-dire la version la plus “brute” et universelle possible. Le modèle analyse le texte comme une suite d’octets, sans avoir besoin d’un tokenizer.

Travailler byte par byte a été tenté auparavant mais ça ralentit énormément le modèle (jusqu’à 5 fois plus lent), car chaque caractère ou morceau de mot devient un élément à prédire.

BLT regroupe les bytes en séquences intelligentes selon une mesure de “facilité” appelée entropie :

En bref, le modèle distribue son effort de manière intelligente : il passe moins de temps sur le banal et plus de temps sur le compliqué (un peu comme quelqu’un qui lit rapidement ce qu’il connaît déjà et ralentit quand il rencontre quelque chose de difficile à comprendre).

Cette façon de faire se rapproche de ce qui existe pour les images, où l'on découpe une image en “patchs” pour l’analyser.

Pour l’instant, ce modèle n’a été entraîné que sur des textes anglais. Mais l’approche pourrait théoriquement s’appliquer à toutes les langues, voire à des contenus non-textuels (images, vidéos), car tout est suite de bytes sur un ordinateur.

Découvrez-ces modèles sur Hugging Face (en accès limité pour l'instant).